Embora a IA ofereça inúmeras oportunidades, também introduz uma série de novas ameaças. A IA generativa permite que agentes maliciosos criem deepfakes e sites falsos, enviem spam e até se façam passar por seus amigos e familiares. Esta postagem explica como redes neurais estão sendo usadas em golpes e em phishing e, claro, compartilharemos dicas para você se proteger. Para uma visão mais detalhada sobre esquemas de phishing com tecnologia de IA, confira o relatório completo na Securelist.

Pig Butchering, catfishing e deepfakes

Os golpistas estão usando bots de IA que fingem ser pessoas reais, especialmente em golpes em sites de relacionamentos. Eles criam personas fabricadas para usá-las ao se comunicarem com várias vítimas simultaneamente para construir fortes conexões emocionais. Isso pode durar semanas ou até meses, começando com flertes leves e gradualmente evoluindo para discussões sobre “oportunidades de investimento lucrativas”. A conexão pessoal de longo prazo ajuda a dissipar suspeitas, mas o golpe, claro, termina quando a vítima investe seu dinheiro em um projeto fraudulento. Esses tipos de esquemas fraudulentos são conhecidos como “Pig Butchering” (abate de porcos), assunto abordado em detalhes em uma postagem anterior. Embora já tenham sido operados por enormes fazendas de golpes no Sudeste Asiático, que empregavam milhares de pessoas, agora esses golpes dependem cada vez mais da IA.

As redes neurais tornaram o catfishing, quando golpistas criam uma identidade falsa ou se passam por alguém, o que é muito mais fácil. As redes neurais generativas modernas podem imitar a aparência, a voz ou o estilo de escrita de uma pessoa com grau suficiente de precisão. Tudo o que um golpista precisa é recolher informações públicas sobre alguém e alimentar a IA com esses dados. Qualquer coisa pode ser útil: fotos, vídeos, publicações e comentários públicos, informações sobre parentes, hobbies, idade, etc.

Portanto, se um familiar ou amigo lhe enviar mensagem de uma conta nova e pedir, por exemplo, que você empreste dinheiro, provavelmente não é realmente essa pessoa. Numa situação dessas, o mais indicado é contatar a pessoa real por outro canal, por exemplo, por meio de ligação, e perguntar diretamente se está tudo bem. Fazer algumas perguntas pessoais cujas respostas um golpista não encontraria online, mesmo em suas mensagens anteriores, é uma atitude inteligente.

Mas a imitação convincente por texto é apenas parte do problema: deepfakes de áudio e vídeo representam uma ameaça ainda maior. Recentemente mostramos como golpistas usam deepfakes de blogueiros populares e investidores em criptomoedas nas redes sociais. Essas celebridades falsas convidam seguidores para “consultas pessoais” ou “bate-papos exclusivos sobre investimentos” e prometem prêmios em dinheiro e sorteios de itens caros.

As redes sociais não são o único lugar onde deepfakes estão sendo usados. Também são gerados para chamadas de áudio e vídeo em tempo real. No início deste ano, uma mulher da Flórida perdeu 15 mil dólares ao acreditar que estava falando com a filha, supostamente vítima de um acidente de carro. Os golpistas usaram um deepfake realista da voz da filha e chegaram a imitá-la chorando.

Especialistas do GReAT da Kaspersky encontraram ofertas na dark web para criação de deepfakes de áudio e vídeo em tempo real. O preço desses serviços varia conforme sofisticação e duração: a partir de 30 dólares para deepfakes de voz e 50 dólares para vídeos. Há apenas alguns anos, esses serviços custavam muito mais: até 20 mil dólares por minuto. E a geração em tempo real não estava disponível.

As ofertas listadas incluem: troca de rosto em tempo real em videoconferências ou apps de mensagens; troca de rosto para verificação de identidade; ou substituição de imagem via telefone ou câmera virtual.

Golpistas também oferecem ferramentas de sincronização labial para qualquer texto em vídeo, inclusive em idiomas estrangeiros, e ferramentas de clonagem de voz que ajustam tom e entonação para uma emoção desejada.

Entretanto, nossos especialistas suspeitam que muitas dessas ofertas na dark web sejam elas próprias fraudes, criadas para enganar outros potenciais golpistas que pagariam por serviços inexistentes.

Como se proteger

- Não confie em conhecidos online que você nunca encontrou pessoalmente. Mesmo que você converse há algum tempo e sinta ter encontrado alguém com afinidade, desconfie se essa pessoa mencionar cripto, investimentos ou qualquer esquema que peça que você envie dinheiro.

- Não caia em ofertas inesperadas e atrativas, aparentemente vindas de celebridades ou grandes empresas nas redes sociais. Sempre verifique nas contas oficiais da pessoa/empresa para confirmar a informação. Se, em qualquer etapa de um “sorteio”, pedirem que você pague taxa, imposto ou frete, ou insira dados do cartão para receber um prêmio em dinheiro, pare e desconfie.

- Se amigos ou parentes mandarem pedidos incomuns, contate-os por outro canal, por exemplo por telefone. Para se certificar, pergunte sobre algo que vocês conversaram na última interação presencial. Para amigos e familiares próximos, combine previamente uma palavra-código que só vocês conheçam. Se vocês compartilham localização, confira e confirme onde a pessoa realmente está. E não ceda à manipulação do “apresse-se”: o golpista ou a IA pode dizer que a situação é urgente e que não há tempo para responder a perguntas “bobas”.

- Se tiver dúvidas durante uma chamada de vídeo, peça que a pessoa vire a cabeça de lado ou faça um movimento complexo com a mão. Deepfakes geralmente não conseguem cumprir tais pedidos sem quebrar a ilusão. Além disso, se a pessoa não piscar ou os movimentos labiais e as expressões parecerem estranhos, isso é mais um sinal de alerta.

- Nunca dite nem compartilhe números do cartão, códigos de uso único ou qualquer outra informação confidencial.

Um exemplo de deepfake que se desfaz quando a cabeça vira. Fonte

Chamadas automatizadas

São uma forma eficiente de enganar pessoas sem precisar falar diretamente com elas. Golpistas usam IA para realizar chamadas automatizadas falsas em nome de bancos, operadoras e órgãos governamentais. Do outro lado da linha, muitas vezes há apenas um bot fingindo ser um atendente. Parece real porque muitas empresas legítimas usam assistentes de voz automatizados. No entanto, uma empresa legítima nunca lhe ligará para dizer que sua conta foi invadida nem pedirá um código de verificação por telefone.

Se receber uma ligação assim, o principal é manter a calma. Não caia em táticas de intimidação como “conta hackeada” ou “dinheiro roubado”. Simplesmente desligue e ligue para o número oficial no site da empresa para contatar a central legítima. Lembre que golpes modernos podem envolver várias pessoas que o transferem de um suposto atendente a outro. Podem ligar ou mandar SMS de números diferentes e fingir ser funcionários de banco, agentes governamentais ou até policiais.

Chatbots e agentes de IA suscetíveis a phishing

Hoje muitas pessoas preferem usar chatbots como ChatGPT ou Gemini em vez dos buscadores tradicionais. Você pode perguntar: quais são os riscos? Bem, grandes modelos de linguagem são treinados com dados de usuários, e chatbots populares já foram observados sugerindo sites de phishing. Ao fazer buscas na web, agentes de IA consultam buscadores que também podem conter links de phishing.

Em um experimento recente, pesquisadores conseguiram enganar o agente de IA do navegador Comet (da Perplexity) com um e-mail falso. O e-mail supostamente vinha de um gerente de investimentos do Wells Fargo, um dos maiores bancos do mundo. Os pesquisadores enviaram o e-mail a partir de uma conta recém-criada no Proton Mail. Incluía um link para uma página de phishing real que estava ativa há dias e ainda não havia sido sinalizada como maliciosa pelo Google Safe Browsing. Ao analisar a caixa de entrada do usuário, o agente de IA classificou a mensagem como um “item a resolver do banco”. Sem qualquer verificação, clicou no link de phishing, abriu a página de login falsa e pediu ao usuário para inserir as credenciais, chegando até a ajudar a preencher o formulário! A IA, essencialmente, endossou a página de phishing. O usuário nunca chegou a ver o endereço de e-mail do remetente suspeito nem o link de phishing. Em vez disso, o usuário foi imediatamente direcionado para uma página de inserção de senha fornecida pelo assistente de IA “prestativo”.

No mesmo experimento, os pesquisadores usaram a plataforma de desenvolvimento web com IA Loveable para criar um site falso que imitava uma loja do Walmart. Em seguida, acessaram o site pelo Comet: algo que um usuário desavisado faria se fosse enganado por um link ou anúncio de phishing. Pediram ao agente de IA que comprasse um Apple Watch. O agente analisou o site falso, encontrou uma “oferta”, adicionou o relógio ao carrinho, inseriu endereço e dados do cartão armazenados no navegador e finalizou a “compra” sem pedir confirmação. Se fosse um site fraudulento de verdade, o usuário teria perdido uma quantia considerável ao fornecer seus dados bancários de bandeja aos golpistas.

Infelizmente, agentes de IA ainda se comportam como iniciantes ingênuos na web, caindo facilmente em engenharia social. Já tratamos em detalhes dos riscos de integrar IA em navegadores e de como minimizá-los. Como lembrete: para evitar ser a próxima vítima de um assistente excessivamente confiável, avalie criticamente as informações fornecidas, limite permissões concedidas a agentes de IA e instale uma solução de segurança confiável para bloquear o acesso a sites maliciosos.

Sites de phishing gerados por IA

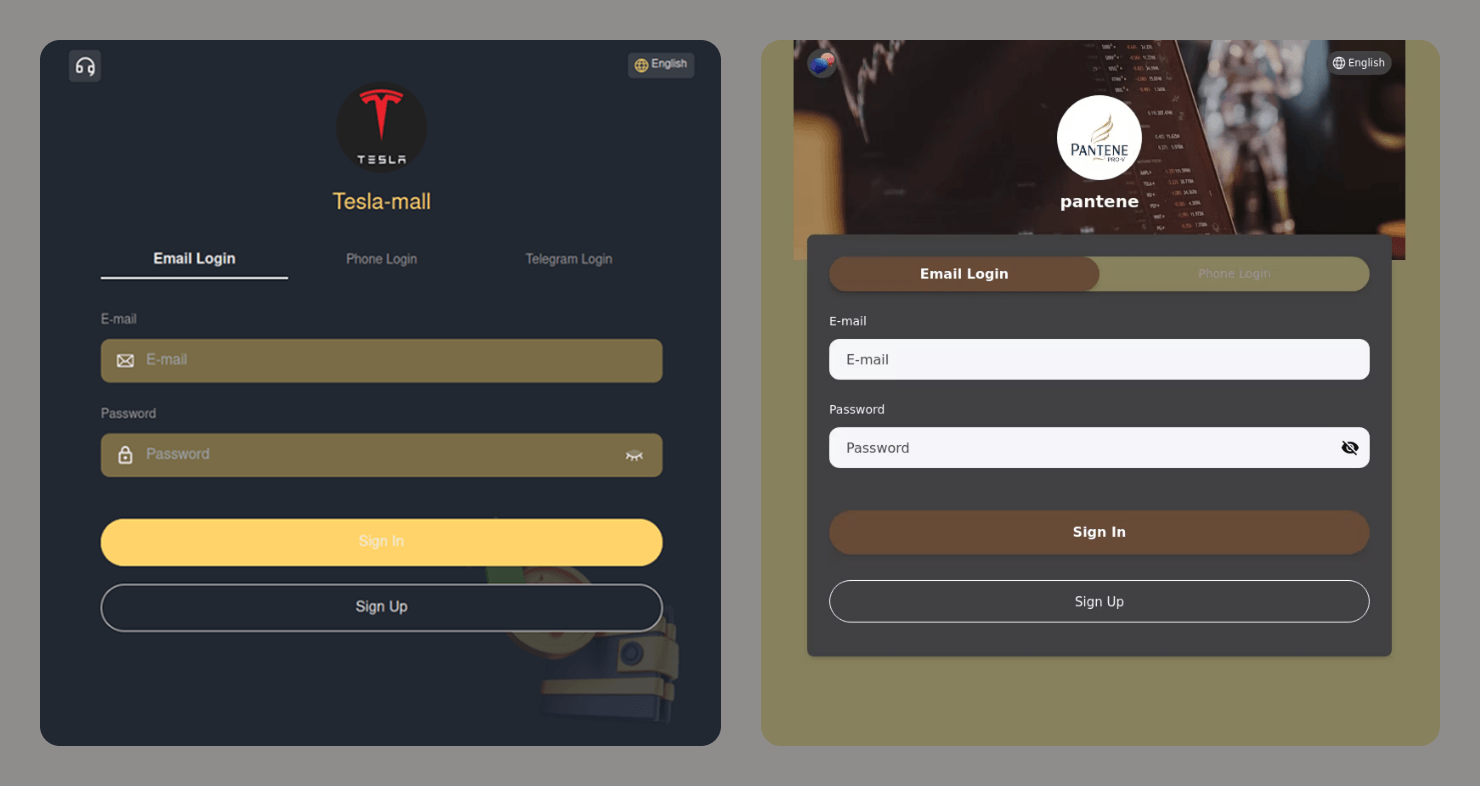

Os dias de sites de phishing feitos de qualquer jeito e lotados de anúncios intrusivos ficaram para trás. Os golpistas modernos fazem de tudo para criar falsificações realistas: usam HTTPS, exibem termos de uso e avisos de consentimento de cookies e têm design bastante convincente. Ferramentas com suporte de IA tornaram a criação desses sites muito mais barata e rápida, por vezes quase instantânea. Você pode encontrar um link para esses sites em qualquer lugar: SMS, e-mail, redes sociais ou até nos resultados de busca.

Como identificar um site de phishing

- Verifique a URL, o título e o conteúdo em busca de erros de digitação.

- Verifique há quanto tempo o domínio do site está registrado. Você pode verificar isso aqui.

- Atente para a linguagem usada. O site está tentando assustar ou acusar você? Ele está tentando atrair você ou apressar sua decisão de agir? Qualquer manipulação emocional é um grande sinal de alerta.

- Ative o recurso de verificação de links em qualquer uma de nossas soluções de segurança.

- Se o seu navegador avisar sobre uma conexão insegura, saia do site. Sites legítimos usam o protocolo HTTPS.

- Pesquise o nome do site online e compare a URL que você tem com a exibida nos resultados de busca. Cuidado: buscadores podem mostrar links de phishing patrocinados no topo dos resultados. Verifique se não há rótulo “Anúncio” ou “Patrocinado” junto ao link.

Leia mais sobre como usar IA com segurança:

- Como as redes sociais da Meta se tornaram uma plataforma para golpes de investimento

- Mais uma vez, você tem direito a uma grande compensação em dinheiro

- Trojans disfarçados de clientes DeepSeek e Grok

- Como fraudadores burlam a verificação de identidade com deepfakes

- Não acredite em tudo o que ouve: deepfakes de voz

phishing

phishing

Dicas

Dicas